Новая модель o1 от Open AI: Почему все недовольны?

В последние годы модели ИИ от крупных компаний становятся объектом пристального внимания и порой вызывают немало споров. Одной из таких разработок стала модель o1 от OpenAI, которая уже успела привлечь как сторонников, так и критиков. В этой статье разберем, почему o1 вызывает противоречивые мнения, и оценим, стоит ли модель тех вложений, о которых заявляют создатели.

О модели

Модель o1 от OpenAI привлекла внимание заявленной способностью «думать» перед тем, как дать окончательный ответ. Этот процесс базируется на методе «Цепочка мыслей» (Chain of Thought — CoT). ИИ разбивает сложные задачи на шаги и анализирует их последовательно. Такой подход помогает модели решать проблемы более эффективно и точно — то есть создается впечатление осмысленного подхода к ответам. Сложные задачи теперь обрабатываются с большей глубиной — и это, конечно, шаг вперед в развитии ИИ. Вот только эта техника далеко не нова.

Отсюда и претензии к детищу OpenAI: компания подошла к релизу этого продукта без прозрачности. Пользователям дали лишь общие описания модели — не озвучили ключевых технических деталей. Это оставило многих в недоумении относительно реальной инновационности о1. По их мнению, компания в рекламе создает ощущение уникальности. Но, как мы упомянули выше — технологии, заложенные в модель, давно известны.

Метод Chain of Thought применялся, в том числе в GPT-4. Фактически, любой пользователь с доступом к API OpenAI или других крупных моделей может создать свою версию CoT, настроив цепочки рассуждений в коде. Это делает сомнительной заявленную революционность: модель, по сути, всего лишь применяет существующую технику без новшеств.

Примеры пользователей подтверждают эту точку зрения. В попытках расспросить модель о работе они получили ограниченные ответы и даже угрозу бана. С этим столкнулись даже те, кто не пытался «залезть под кожу» ИИ:

I have developed a reflection webui that gives reflection ability to any LLM as long as it uses openai compatible api, be it local or online, it worked great, not only a prompt but actual chain of thought that you can make longer or shorter as needed and will use multiple calls I have seen increase in accuracy and self correction on large models, and somewhat acceptable but random results on small 7b or even smaller models, it showed good results on the phi-3 the smallest one even with quantization at q8, I think this is how openai doing it, however I was like lets prompt it with the fake reflection 70b prompt around. but let also test the 01 thing, and I gave it the prompt and my code, and said what can I make use of from this prompt to improve my code. and boom I got warnings about copyright, and immediately got an email to halt my activity or I will be banned from the service all together. I mean I wasn't even asking it how did 01 work, it was a total different thing, but I think this means something, that they are trying so bad to hide the chain of though, and maybe my code got close enough to trigger that.

Но преимуществ много

Несмотря на критику, o1 действительно обладает преимуществами. Уникальна технология в основе или нет, но она позволяет ИИ генерировать не просто финальные выводы. Нейросеть пошагово размышляет о каждом этапе решения. Такой подход позволяет лучше справляться с более сложными проблемами, где важны не только точные ответы, но и правильная логика рассуждений. Например, в математике или программировании модель постепенно разворачивает каждый этап вычисления.

Представьте задачу — решить уравнение, где необходимо не просто получить итог, а рассчитать все промежуточные значения. Модель o1 при использовании Chain of Thought предлагает шаг за шагом:

- Обсуждение переменных.

- Формирование уравнений.

- Пошаговое решение.

- Проверку на каждом этапе.

В итоге пользователи могут убедиться в правильности вычислений, проверив данные каждого шага.

В отличие от простых моделей, где используются только предварительно обученные данные, o1 активно обучается с использованием сложных техник подкрепления. Это делает ее более адаптивной к новым задачам и улучшает качество промежуточных выводов. Однако даже эта технология имеет ограничения: слишком длинные цепочки могут в конечном итоге привести к искажениям. Модель теряет нить рассуждений. Тем не менее такие проблемы возникают реже, чем в более простых ИИ-системах.

Вернемся к уникальности

С GPT и Python можно создать свою альтернативу «уникальной модели». Она, конечно, будет уступать оригиналу, но сможет с ним состязаться. Первый шаг — настроить цепочку рассуждений, на которой базируется o1. GPT уже поддерживает этот функционал, нужно только обучить модель задавать себе промежуточные вопросы или шаги для решения задачи. Для создания более сложных процессов можно разбить промт на несколько отдельных цепочек.

Звучит сложно, но вполне реально. И при этом у вас не будет ограничений по количестве запросов. На это пользователи жалуются чаще всего: в неделю для o1 доступно 30–50 промтов.

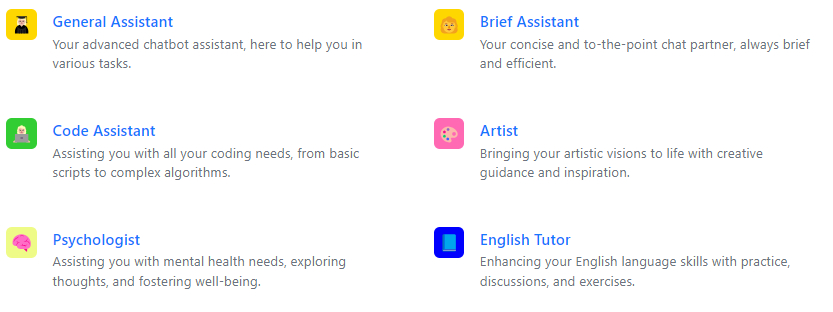

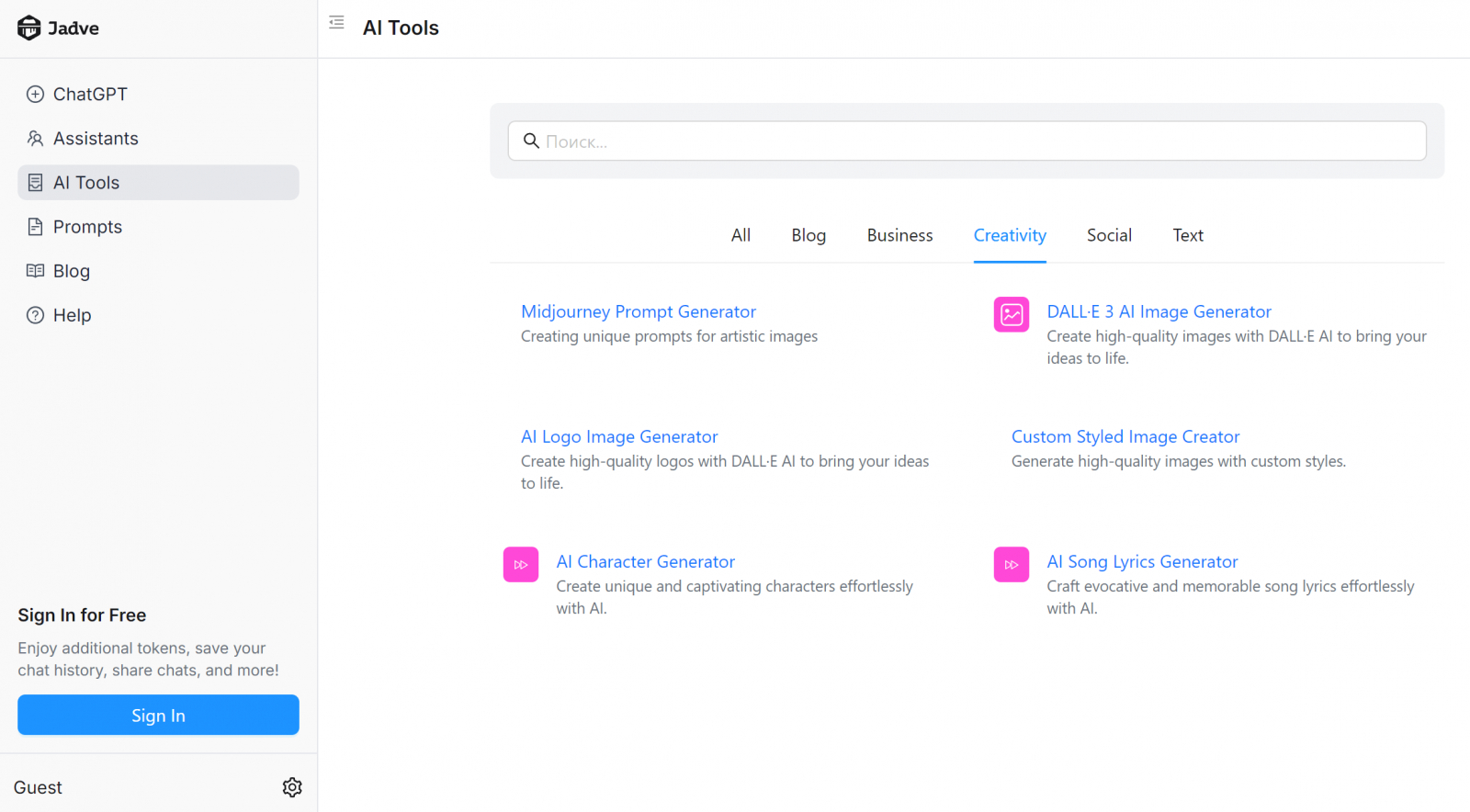

Есть, конечно, более простое решение проблемы, без лимитов и кодирования — пользоваться существующими ИИ с большим функционалом. С Jadve AI, например, не нужно заниматься программированием, чтобы создавать отчеты, анализировать данные или автоматизировать маркетинговые кампании. В нейросеть уже залили промты для разных задач: от SEO до работы с психологом.

Что пользователи думают об o1

Модель пока доступна только владельцам Plus и Team. Они и протестировали на ней разные задачи. Первое, что сделали — провели классический тест «strawberry». Проверили, как модель справляется с базовыми задачами распознавания текста — подсчетом букв «r» в слове strawberry.

Тонкость в том, что GPT-4o проваливает эту задачу, потому что ИИ обрабатывает текст в виде токенов. Фрагментов, которые могут включать не целые слова или буквы, а их сочетания. В случае слова «strawberry» токены разбиваются на «straw» и «berry», и модель не видит все буквы «r», что приводит к ошибке.

Однако модель o1-preview, в отличие от GPT-4o, успешно проходит этот тест. Помогает система многопроцессорного анализа. Судя по всему, модель o1-preview работает по принципу «менеджера GPT». Создает несколько вспомогательных моделей для решения задачи. Например, в тесте «strawberry» один GPT-модуль выделяет буквы в слове, другой проверяет их и возвращает ответ. Затем еще один модуль проверяет результат и отправляет его на финальную оценку. В конце концов, пользователь получает подтвержденный ответ.

Однако не все отзывы о модели были восторженными. Пользователи, работающие с креативными задачами, выразили недовольство. Модель o1 не поддерживает генерацию изображений и не справляется с творческими задачами. Написать главу для романа или отредактировать текст она не может.

Модель совсем не так универсальна, как ее предшественники. Многие задаются вопросом, стоит ли тратиться на платформу с ограничениями, если другие нейросети предлагают больше инструментов. Пример — на скриншоте.

Еще одно разочарование пользователей — скорость работы. Поскольку o1-preview вынуждена выполнять несколько шагов для решения задач, это занимает больше времени. Некоторые пользователи жалуются, что ожидание ответа может занимать до минуты. Это неудобно, если ответ нужен здесь и сейчас. Дедлайны, в конце концов, никто не отменял.

Плюсы, минусы, сравнение

Итак, что имеем. Преимущества модели o1:

- Точность в решении сложных задач. Модель отлично справляется с программированием и научными исследованиями. Она использует пошаговый процесс, что позволяет ей находить правильные решения даже для сложных логических задач.

- Метод пошагового анализа. Благодаря механизму последовательных шагов и проверки промежуточных результатов o1 обрабатывает большой объем информации. Это, опять же, полезно для сложных вычислений и исследований.

Недостатки:

- Медленная производительность. Требуется много времени на обработку пошаговых решений.

- Ограниченные возможности для творчества. Модель не подходит для создания текстов, генерации идей и большинства SEO-задач. Она не поддерживает функции генерации изображений.

- Ограниченный функционал. Модель лишена функций, которые есть у других нейросетей: запоминание, загрузка файлов и просмотр страниц в интернете.

Сравним? o1 vs GPT-4:

GPT-4 более универсальна и быстрее в простых и общих задачах. Она поддерживает генерацию текста и изображений, написание статей, редактирование и творческие задачи. Модель o1 медленнее и ориентирована на точные логические задачи.

o1 vs GPT-4o:

Модель GPT-4o, как и GPT-4, демонстрирует высокую скорость и универсальность, но может допускать ошибки в сложных логических задачах. Пример: strawberry-тест. Модель o1, наоборот, лучше справляется с анализом сложных проблем за счет пошагового подхода, но это, опять же, делает ее менее быстрой.

o1 vs Jadve AI:

o1 и Jadve AI используют разные подходы к использованию ИИ. Второй ориентирован на простоту и многофункциональность. Он предлагает готовые решения для пользователей — человеку нет нужды использовать глубокие технические знания. Это делает его идеальным для маркетологов, контент-менеджеров и других специалистов, которым нужны быстрые и универсальные инструменты, но не требуется такая точность и глубина, как у o1.

o1 vs другие LLM (например, Claude или LLaMA):

Многие современные языковые модели обеспечивают баланс между скоростью и точностью. Claude предлагает улучшенное понимание контекста и творческие способности, но o1 превосходит его в задачах, где требуется многопроцессорный анализ. LLaMA быстрее, но точность в решении специализированных задач уступает o1.

Наш вывод: модель o1 — большое достижение в области ИИ. Подход к анализу и обработке информации делает ее мощным инструментом. Но медлительность работы и малый функционал ограничивает ее пользу. o1 не универсальное решение для всех задач. И пока OpenAI не усовершенствовали технологию, пользователям проще пользоваться более доступными платформами.